关于【2020年是建党多少周年】,2020年是建党多少年呢,今天犇涌小编给您分享一下,如果对您有所帮助别忘了关注本站哦。

内容导航:1、ICCV | Adobe提出短视频集锦自动生成新方法,准确度提升4%~12%2、2020年是建党多少周年:2020年是建党多少年呢1、ICCV | Adobe提出短视频集锦自动生成新方法,准确度提升4%~12%

机器之心专栏

Adobe Research

Adobe Research 的研究人员提出一种针对以人为主体的视频的自动高亮集锦生成的方法,在无需任何人工注释和用户偏好信息来完成训练的前提下,该方法比现有最优方法在匹配人工注释的准确度上提升了 4%~12%。

以人为中心的视频是关注人类执行和表达活动、任务和情感的视频。这种类型的视频极大地促进了离线和在线个人和共享媒体的快速增长。这些视频来自多个领域,如业余体育和表演、讲座、教程、视频博客(vlog),以及个人或团体活动,如野餐、假日旅行。然而,未经编辑的以人为中心的视频也往往包含大量无关和无趣的内容,需要对它们进行编辑和标记,以便高效浏览。

为了解决这个问题,许多方法探索了自动检测高亮片段或摘录和总结视频的技术。对于未经编辑的镜头,高亮检测的目的是获取预先定义的兴趣时刻,而提取概要的目的是计算最相关和最有代表性的摘录。检测有效的高亮内容不仅可以加快浏览速度,还可以提高高亮内容被分享和推荐的几率。现有方法通过有监督学习来实现这样的高亮检测,但必须依赖于:人工标记的高亮片段,或不同高亮类别的示例。另外,这些方法并没有明确地模拟人类活动或人际互动,而实际生活中大部分视频的主要焦点都与此密切相关。

能否在无需人工注释的前提下,生成对以人为中心的视频的高亮集锦?近日,我们提出了一种针对以人为主体的视频的自动高亮集锦生成的方法,在无需任何人工注释和用户偏好信息来完成训练的前提下,该方法比现有最优方法在匹配人工注释的准确度上提升了 4%~12%。该工作已被 ICCV 2021 接收。

论文链接:https://arxiv.org/pdf/2110.01774.pdf

如希望进一步交流,欢迎联系作者:

Gang Wu (gawu@adobe.com),

https://wugangwu.github.io

在这篇论文中,我们提出了一种领域和用户偏好无关的方法来检测以人为中心的视频中的高亮片段。我们使用基于图表达的方法作为视频中多个可观察到的以人为中心的模式,如姿势和面孔。我们使用一个配备了时空图卷积的自动编码器网络来检测基于这些模式的人类活动和交互。我们基于帧的代表性训练我们的网络,从而将不同模式的基于活动和交互的潜在结构表示映射到每帧的高亮得分。我们使用这些分数来计算突出哪些帧,并结合相邻帧来产生摘录。我们在大规模动作数据集 AVA-Kinetics 上训练我们的网络,并在 DSH、TVSum、PHD 和 SumMe 四个基准视频高亮数据集上评估网络。在这些数据集中,与最先进的方法相比,我们在不需要任何用户偏好信息或对新数据集调参的情况下在匹配人工标注的高亮上的平均精度上提高了 4%-12%。

1. 引言

以人为中心的视频是关注人类执行和表达活动、任务和情感的视频 [62,50]。这种类型的视频极大地促进了离线和在线个人和共享媒体[8] 的快速增长。这些视频来自多个领域,如业余体育和表演、讲座、教程、视频博客(vlog),以及个人或团体活动,如野餐、假日旅行。然而,未经编辑的以人为中心的视频也往往包含大量无关和无趣的内容,需要对它们进行编辑和标记,以便高效浏览[47]。

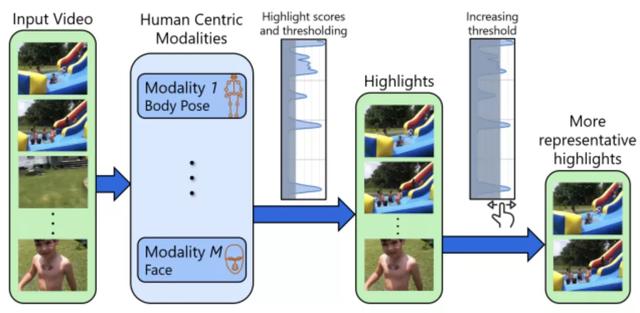

图 1:使用以人为中心的模式检测高亮摘录。我们的方法利用了多种以人为中心的模式以检测亮点,例如,可以在关注人类活动的视频中观察到的身体姿势和面部。我们使用每个模态的二维或三维互联点表示来构建一个时空图表示来计算高亮分数。

为了解决这个问题,许多方法探索了自动检测高亮片段或摘录和总结视频的技术 [11,53,42,63,44,67]。对于未经编辑的镜头,高亮检测的目的是获取预先定义的兴趣时刻,而提取概要的目的是计算最相关和最有代表性的摘录。检测有效的高亮内容不仅可以加快浏览速度,还可以提高高亮内容被分享和推荐的几率[53]。现有方法通过有监督学习来实现这样的高亮检测,但必须依赖于:人工标记的高亮片段[47,11],或不同高亮类别的示例,例如,从滑雪图像学习来检测视频中的滑雪高亮片段[23,25]。其他方法通过学习每一帧或拍摄相对于原始视频[36] 的代表性,并利用视频元数据,如持续时间 [53] 和拍摄 [67,64] 的相关性,从而消除了监督的需要。所有这些方法要么假设或符合未编辑片段的一些特定领域的知识,例如,跑步和跳跃可能在跑酷视频中更相关,而滑动动作可能在滑雪视频中可能更相关。其他方法不考虑特定领域的知识,不用检测个性化的亮点[42],而是考虑多个用户预先记录的偏好。

无论它们是假定特定领域的知识还是用户偏好,现有的方法都可以在构成视频的帧或镜头的二维图像空间中工作。最先进的基于图像的网络可以学习丰富的语义特征,捕获图像中各种检测对象之间的相互关系,从而实现有效的高光检测。然而,这些方法并没有明确地模拟人类活动或人际互动,而这些都是以人为中心的视频的主要焦点。与此同时,开发以人为中心的视频的方法对于各种任务至关重要,包括表达和情绪识别 [34,2,38]、活动识别[56]、场景理解[50,32]、人群分析[51]、视频超分重建[32] 和基于文本的视频捕捉[48]。这些方法表明,以人为中心的视频需要与普通视频分开处理,通过利用以人为中心的模式,如姿势和面孔。因此,这表明了将以人为中心的视频理解机制带到高亮检测任务中的余地和必要性。

我们开发了一个端到端学习系统,它可以检测以人类为中心的视频中的高亮显示,而不需要特定领域的知识、高亮显示注释或示例。我们的方法利用通过多种感觉通道或方式表达的人类活动和互动,包括面孔、眼睛、声音、身体姿势,手势[1,38]。我们对所有以人为中心的模式使用基于图的表达方式,来充分表示每个模式的固有结构包括各种活动和交互是如何随着时间的推移而演变的。我们的网络使用时空图卷积从这些基于图的表示中学习,并使用自动编码器架构映射每帧模式到高亮分数。我们的高亮分数是基于视频中所有帧的代表性,将连续的帧拼接在一起,通过产生最终的摘录来得到的。我们的新贡献包括:

使用以人为中心的模式的高亮检测。我们的方法在每个输入视频中识别可观察到的模式,如姿态和面孔,并将它们在时间和不同人的相互关系编码为高亮分数,用于高亮检测。高亮分数的无注释训练。我们不需要突出显示注释、示例、用户偏好或特定于领域的知识。相反,我们只需要使用现成的模式检测技术来检测一个或多个以人为中心的模式来训练我们的高亮分数。与域和用户无关的性能。我们训练过的网络在由以人为中心的视频组成的多个基准数据集上进行评估,并在不同领域和用户偏好上的高亮检测方面实现了最先进的性能。我们的方法在基准特定领域的视频高亮 (DSH) 数据集 [47] 和个人高亮检测数据集 (PHD2)[11] 数据集上匹配的人工注释高亮片段的平均精度分别为 0.64 和 0.20,比相应的现有方法高出 7% 和 4%(绝对值)。我们还在 TVSum[46]和 SuMMe[15]较小基准数据集上实现了最先进的性能,在平均精度和平均 F 得分上分别比目前最先进的基线方法高出 12% 和 4%(绝对值)。即使对于不完全以人为中心的领域(例如,狗展)或未检测到足够以人为中心的模式的视频,我们方法的性能也可与当前最先进方法相媲美。

2. 相关工作

视频摘要的突出检测和密切相关问题已经在计算机视觉、多媒体和相关领域得到了广泛的研究。早期的方法使用了包括基于可视化内容的聚类、场景转换图、帧 [59,6,49] 的时间方差和表示语义信息的手工特征,如面部活动 [20] 的各种技术。另一方面,最近的方法利用了一系列令人印象深刻的深度学习工具和技术来实现高亮检测和视频总结。

高亮检测。高亮检测的目标是检测视频感兴趣时刻或未经编辑视频的摘录 [49,47]。大量方法将此视为监督排名问题,因此高亮摘录的排名高于所有其他摘录[47,17,58,18,11,60,19,52]。这些方法假设了高可读摘录的人类注释标签的可用性,并训练网络学习与这些标签相关的通用或特定领域的排名指标。另一方面,弱监督和无监督的高光检测方法通过利用示例或视频元数据,消除了标签依赖性。这些样本包括描绘了特定领域的动作的网络图像,如体操和滑雪[25]。视频元数据包括关于视频类别[57] 的信息,或有助于区分未编辑视频和编辑视频的属性,例如持续时间[53]。一些方法还考虑到用户的偏好来生成个性化的亮点[42]。所有这些方法都在每一视频帧的二维图像空间中执行计算,并且不使用以人人为中心的模式。

视频摘要。视频摘要的主要目标是提供各种格式的简洁的视频合成,包括故事线图 [24,54]、关键帧序列[30]、剪辑[15,64],以及基于用户需求[14] 的混合物。视频摘要通常被认为是一个满足一致性 [35]、多样性,和代表性[40,67] 的无监督子序列估计任务。无监督摘要方法建立在多个概念之上,如视觉共现 [7]、视频帧和镜头之间的时间相关性[23,36,44,64]、学习类别感知分类器[41] 和类别感知特征学习 [66,46]。其他方法采用弱监督的方法,使用范例网络图像和视频[24,22,4,43],以及类别描述[41,40] 作为先验。然而,另一些方法使用监督学习与人类注释的摘要,使用子集选择 [13]、视觉重要性评分[30,15]、子模块混合[16,55] 和时间相互关系[63,64,65]。虽然我们的目标是高光检测,但我们的方法受到这些视频摘要方法的启发。特别是,我们确保我们的亮点分数捕捉到了视频中的代表性并能够进行稳健的特征重建。

多模态学习。大量工作都集中在多模态动作识别 [5,45,33,10] 和情绪识别 [3,26,61,38,39] 上。这些方法观察并结合了来自多种人类表达方式的线索,包括面部、姿势、声调、眼球运动、手和身体手势和步态。现有方法通常使用点和图 [33,3,38] 对观察模式进行建模,使它们适合学习动作和情绪的特征。在我们的工作中,我们利用了这样一个事实,即以人类为中心的视频的高摘录可以根据这些模式来确定。根据多模态动作和情绪识别 [33,38] 的最新趋势,我们还将视频中各帧中观察到的模式建模为时空图,并利用它们来学习我们的高亮分数。

3. 多模式高亮检测

对于以人为中心的视频,我们的目标是从视频中检测出感兴趣的时刻或亮点。本节详细介绍了我们如何通过利用从视频中观察到的以人为中心的模式来检测这些亮点。

3.1. 人类中心模式

在我们的工作中,我们使用术语 “模式” 来暗示对人类活动和交互作用敏感的人类表达通道,例如,面孔、眼睛、身体姿势、手、步态 [5,38,39]。活动由个体的表达和互动构成,包括与他人、其他生命和无生命的物体的互动,并与各种行动[56,10] 和情绪 [2,39] 有关。我们认为人类更喜欢以人类为中心的视频,来关注这些活动和互动。因此,我们的目标是从我们的网络中观察到以人类为中心的模式进行学习。对于检测到的每个人的模态,我们的网络利用不同时间实例的相互关系以及不同人之间的相互关系来检测最具代表性的摘录。

当我们从视频帧的 RGB 图像空间表示中提取这些模式时,我们注意到这些模式比一般的图像空间表示更能捕获到丰富的视频帧语义信息。图像空间表示建立在图像不同部分之间强度差异的变化基础上,而没有对不同部分如何相互作用进行理解。另一方面,模式提供了基于其结构的互动洞察,例如,利用手臂和腿的相对动作来表示某些动作,以及各种面部标志的相对运动来表示某些表情和情绪。我们建立我们的网络来明确地考虑每个模态的结构,以及这些结构包括活动和相互作用随着时间的演变。

我们考虑从输入视频中可观察到的 M≥1 的以人类为中心的模式。我们假设这些模态是使用标准的模态检测和跟踪技术 [29,12] 提取的,并使用一组二维或三维的互联点来表示,例如一组二维面部地标或一组三维身体关节的姿势。

为了表示每个模态 m=1,…,我们构建了一个时空图表示 Gm={Vm,Em}。Vm 中的节点表示相应模态的点,Em 中的边表示模态的结构以及该结构如何随时间的演化。为了充分捕捉到这一点,我们考虑了三种边类型:

人内边捕捉单个人节点之间的空间关系,例如,姿势关节之间的骨骼和面部地标之间的连接器。这些边代表了在每个视频帧上模态的基线结构。人际边连接每个视频帧中不同人的相同节点,例如,根到根、头对头。这些边捕捉了不同人的节点相互交互关系。它们为每一对人形成一个二部图,表示每个视频帧上的人际交互。同时边是一个人在多个视频帧上连接的相同节点,例如,根到根、头对头。这些边捕捉了每个人的节点是如何随着时间而演变的。它们为每一对视频帧形成一个二部图,表示活动和交互随时间的演变。这些节点的空间位置和所有这些边的组合使我们的网络能够学习视频中所有人类的活动和互动,并相应地学习高亮分数,而不需要任何关于视频领域或用户提供的偏好的先验知识。

3.2. 视频帧的代表性

由于我们的目标是在不需要注释或示例的情况下检测视频中的亮点,因此我们的方法与检测视频中的代表帧一致,类似于视频摘要中已完成的工作 [36, 14]。虽然检测图像空间中的代表帧有可能或没可能有利于检测视频的感兴趣时刻[47],但我们观察到,事实上检测以人为中心的模式空间中的代表帧,是有利于在以人为中心的视频中检测感兴趣时刻。

我们将视频帧的代表性定义为在某个度量空间中,视频和没有该帧的视频之间的差异。差异越大,该框架的代表性就越高。直观地说,帧的代表性衡量它包含的与整个视频相关的信息的比例。我们在高亮检测方面的目标是从具有最大代表性的视频中检测到最小的帧集。

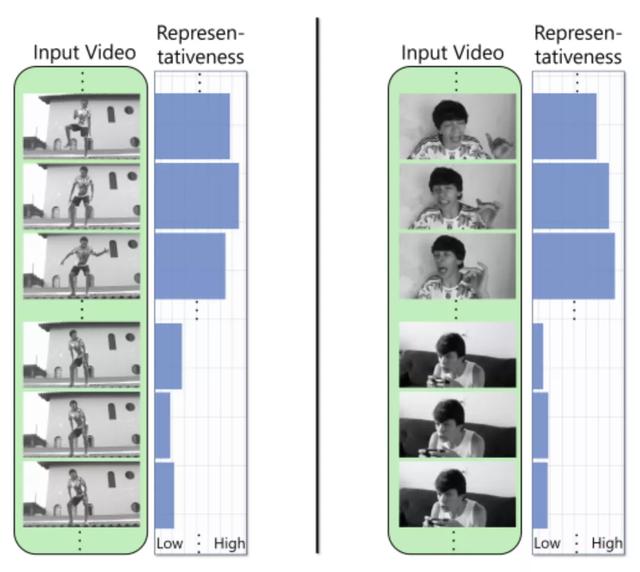

图 2:代表性。我们展示了不同视频帧在姿态(左)和地标(右)计算的不同代表性值。我们根据代表性来学习高亮分数。

在我们的工作中,我们测量了可观测模式的度量空间中的代表性。图 2 显示了姿态和地标空间中不同代表性值的视频帧示例。我们认为每个视频都由一个总的 T 帧和 P 人组成(具有较少的帧和人的视频是适当的用零填充的。因此,对于每个模态 m,Vm 总共由 N×T×P 节点组成,其中 N 为每人的节点数。我们将这些节点整理成一个张量

,其中

是指每帧 t,D 是每个节点的空间维数,最常见的是 2 或 3。

接着,我们可以将高亮分数

置为 0 或 1 以反映每帧 t 的代表性。因此,我们可以将净差值 D 作为将高亮值写为,

(1)

其中

表示Hadamard的结果。我们现在可以将我们的目标重写为公式 1 中的最小化D。

同时对于每个模态m也最小化

。我们注意到方程的一个平凡的解。1 是选择一个阈值 0≤τ≤T,然后从 Xm 中最具代表性的顶级 τ 的高亮分数为 1,对所有其他帧的高亮分数为 0。然而,选择 τ 并不简单,在实践中需要从数据中学习。因此,我们训练了一个基于自动编码器的深度神经网络来学习广泛数据的高亮分数。我们还允许高亮分数在[0,1]中是连续的,以保持我们的网络的可微性。此外,使高亮分数连续也有助于我们理解每一帧的相对代表性,这是现代高亮检测系统[53,42]的一个内置组件。

3.3. 网络架构

图3显示了我们用于预测从输入视频中得到高亮视频片段的整体网络架构。我们网络的目标是学习每一帧高亮的分数,以最小化一个类似公式1的形式。我们的网络通过采用可观察的每帧基于图的表示来实现这一点。它试图使用尽可能少的输入模式的帧来重建视频中的所有活动,即加权重建,其中权重是高亮的分数。在训练过程中,我们的网络学会了为具有更高代表性的帧分配更高的高亮分数。我们将详细描述我们的网络架构。

图3:使用以人为中心的模式的高亮检测:我们的学习网络概述,突出显示来自多种以人为中心的模式的分数。我们使用标准技术[29,12]来检测以人为中心的模式。我们将这些模式表示为二维或三维中的连接点集合。我们并行地训练所有模式的网络。网络之间唯一的交互点是他们预测的高亮分数,我们将其合并到我们的加权高亮分数中进行训练。

我们的自动编码器架构由一个编码器、一个得分器和一个解码器组成。我们的编码器从一个输入视频中获取每个可观察模态m的时空图表示

。

它使用一个单独的时空图卷积网络(STGCN)[56,28,9]将每个模态m的

转换为基于潜在活动的特征

,Dl是潜在特征中每个节点的维数。因此,我们有了如下操作,

其中,

表示由

得到的邻接矩

阵,

由编码器中的一组可训练的STGCN参数组成。

我们在这里注意到数据

形成了一个全秩张量,因此STGCN避免了将0的退化解分配给所有

。

我们基于活动的潜在特征

连接到我们的得分器,它由一层时空图卷积组成,然后是每个模态的s型操作。我们的得分器将每个

转换为

每个节点的标准化高亮分数

,即,

(3)

其中

表示s型函数,

由可训练STGCN参数组成。

我们的解码器采用基于潜在活动的特征

和每个模态m的亮点得分

,并通过与每个节点形成

的 Hadamard 积来产生加权潜在特

征

的维数,即

(4)

换句话说,我们的目标是选择

中对应于

中最具代表性的帧的潜在特征。在训练过程中,我们的得分器成功地学会了将更高的

值分配给代表更具代表性帧的

特征,并在重建过程中有利于它们。

从加权潜在特征

中,我们的解码器使用另一个STGCN生成输入图节点的重建

,即

(5)

其中由解码器中的一组可训练的STGCN参数组成。

3.4. 训练损失函数

类似于公式1,我们训练我们的网络架构,以最大限度地重构所有模式下的输入图节点,同时最小化考虑用于重构的帧数。我们的方法是基于这样一个假设,即具有更高代表性的视频帧,构成了更清晰的视频摘录。因此,实际上我们的目标是在输入视频的重建中抑制尽可能多的帧,同时只强调具有高代表性的帧。

给定每个模态的突出分数

,我们执行所有维度的最大的分数池,但获得

,该模态视频的每帧的最大突出分数,即

(6)

我们还考虑了每个模态m的

加权贡献,这样权重就与输入视频中模态可见的帧数成正比。如果该模态的一半以上的组成点在帧中可见,那么我们定义一个模态在帧中是可观察到的。

根据这个定义,我们为每个模态m构造一个权值

为

(7)

注意

,因为每一帧可以包含无和所有模式之间。

紧接着,我们为视频的所有帧构造加权突出显示分数

作为

(8)

最后,给定解码器重建

和每个模态的权重

,我们构建我们的损失函数 L来训练我们的网络

(9)

其中合并所有可训练参数

、

和

,

为正则化因子。

4. 实施和测试

我们在大规模的AVA-Kinetics数据集[31]上训练我们的网络。该数据集由235个训练视频和64个验证视频组成,每个15分钟,并在1秒的剪辑中标注动作标签。我们忽略了动作标签,并使用原始视频来训练和验证我们的高亮检测网络。该数据集由各种各样的人类活动组成,但没有监督一些精彩的摘录。因此,它适合于我们的学习任务,以检测人类特有的突出显示摘录。由于内存限制,我们以30秒不重叠的节录处理每个视频,总共有7050个训练节录和1920个验证节录。

4.1. 实施

我们使用M = 2的模式、姿态和人脸,这是我们在所有数据集中测试我们方法最容易观察到的两种模式。其他模式,如手势和眼球运动,要么很少可见,要么有噪声检测。我们根据CMU泛视模型[21,37]建立姿态图,并根据Geitgey[12]的面部地标模型建立面部地标图。

我们使用最先进的多人跟踪器[29]来跟踪所有视频帧中的人,并用最先进的姿态探测器[37]和面部地标探测器[12],来分别检测他们的姿势和面部地标。

为了给每个模态构建图,我们考虑了每一帧中最多P = 20的人,并考虑了结合过去和未来的时间边到30f的时间相邻帧,f是处理视频的帧率。当可用时,我们在过去和未来使用相同数量的帧来进行时间邻接。我们已经观察到了在2到5帧率的准确性和内存需求方面的有效性能,在我们的实验中使用帧率f=5。

我们使用Adam优化器[27]训练200轮,批处理尺寸大小为2,初始学习率为10-3,动量为0.9,权重衰减为10^-4。在每轮训练之后,我们的学习率都会降低0.999倍。在英伟达GeForce GTX 1080Ti GPU上大约需要40分钟,总训练时间约为4.6个GPU天数。

4.2. 测试

在测试时,我们根据公式8得到输入视频所有帧的加权突出显示分数。我们将高于某个分数阈值的所有连续帧组合起来,以生成视频精彩片段。我们还可以使用类似于[44]的方法连接摘录来创建基线视频摘要。根据我们的实验结果,我们观察到当≥0.5能够检测到基准数据集中具有代表性的高光片段。

在实践中,我们将通过提供一种机制来对摘录进行排序,将给定视频的最终选择留给用户。我们为每个高亮片段分配一个分数,即其每个组成帧的加权高亮分数的平均值。我们根据这些分数对摘录进行排序,这样用户就可以选择自己的阈值来获得超过这些阈值的摘录。他们选择的阈值越高,在阈值下存活下来的摘录就越少,从而减少了他们筛选较不具代表性摘录的人工工作量。

5. 实验

我们在两个大规模的公共基准数据集上评估了我们的方法和目前最先进的视频高亮检测方法的性能:领域特定重点(DSH)数据集[47]和个人重点检测数据集(PHD2)[11]。我们还在较小公共数据集TVSum[46]和SumMe[15]上进行了评估。然而与当前任何方法不同的是,我们都没有在这些数据集上训练或微调我们的方法。我们还通过从训练和评估中删除单个模式来测试我们网络消融版本的性能。

5.1. 数据集

DSH数据集[47]由YouTube上横跨六个特定领域类别的视频组成:狗的表演、体操、跑酷、滑冰、滑雪和冲浪。每个域中大约有 100个视频,总时长约为 1,430 分钟,大约有 600个视频。PHD2数据集[11]的测试集由总共约10万个YouTube视频组成,总计约55800分钟,由850名用户根据其偏好标注的高光片段组成。更小一些的TVSum数据集[46]有50个YouTube视频,总计约210分钟,横跨10个领域:养蜂(BK)、自行车技巧(BT)、狗展(DS)、闪耀(FM)、梳理动物(GA)、制作三明治(MS)、游行(PR)、跑酷(PK)、车辆轮胎(VT)和车辆松开(VU)。SumMe数据集[15]只有25个个人视频,总计约66分钟。

5.2. 评估指标

我们使用与相应视频中注释高光匹配的检测高光的平均精度(mAP)来评估所有方法。平均精度是评价高光检测[47,17,11,53,42]的常用度量。我们注意到,在评估高亮的情况下,每个视频的精度需要单独考虑,而不是跨视频考虑。这是因为从一个视频中检测到的高亮片段不一定比另一个视频[47]的非高亮片段有更高的高亮分数。我们还报告了我们的方法在所有数据集和基线方法在SumMe数据集[15]上的平均F分数(精度和召回率的谐波平均值,通过计算所有视频上数据的平均值得到)。

5.3. 基线方法

我们与DSH数据集[47]上的4个基线、PHD2数据集[11]上的4个基线、TVSum数据集[46]和SumMe数据集[15]上的7个基线进行了比较。我们报告了如文献中所述的基线方法的性能。

在DSH数据集上,我们与Sun等人的潜在基于SVM的高亮排序方法(LSVM) [47]、使用具有完全连接层学习的C3D特征进行高亮排序的Video2GIF方法[17]、Yang等人基于无监督鲁棒循环自动编码器的方法(RRAE) [57]和Xiong等人的方法(越少越多)[53]进行了比较。Xiong等人的方法通过使用视频的持续时间作为弱监督标签来学习对高光进行排序,并认为较短的视频更有可能被编辑,从而更容易曝光。

在数据集PHD2上,我们再次与方法Video2GIF [17]进行比较,使用GoogLeNet的完全卷积序列网络(FCSN)来学习基于图像的特征来高亮检测[44],以及自适应FCSN方法(ADFCSN)[42],它还包括一个历史编码器来适应用户的历史重点偏好来检测个性化的亮点。我们还依据[42]使用一个完全随机的高亮检测器作为最低基线方法。

在TVSum数据集上,我们再次与基于持续时间的高光检测方法(LessisMore)[53]、Chu等人基于视觉相关的使用最大双峰发现(MBF)来获得与原始视频相关并发镜头的方法[7]、Potapov等人基于内核在语义一致的片段上训练SVM的视频总结方法(KVS)[41]、Panda等人的使用共识正则化器来检测满足稀疏性、多样性和代表性的突出显示片段的协作视频总结方法(CVS) [40] 以及马哈塞尼等人的使用具有对抗性损失的LSTM(Adv-LSTM)无监督视频总结方法[36]进行比较。

在SumMe数据集上,我们再次比较了Gygli等人[15] 基于兴趣度总结的(Int.)自适应FCSN(Ad-FCSN)[42]、Gygli等人[16]基于子模块化的总结方法(Sub.)、Zhang等人[63]采用行列式点过程(DPP-LSTM)的LSTM网络、基于 GAN 和额外监督 (GAN-S)的方法[35],Zhou 等人基于深度强化学习的具有额外监督的方法(DRL-S) [67]以及使用编码器-解码器体系结构从序列数据中检测具有高度相关性片段的检测方法(S2N)[52]。

5.4. 结果

DSH[47]和TVSum[46]。我们分别在表1和表3中报告了DSH和TVSum数据集中所有域的mAP。除在少数领域之外,我们的方法都优于基线方法。这些非最优的领域要么不是完全以人类为中心(养蜂、狗展、梳理动物和制作三明治),要么由于在视频中没有检测到足够的姿势和脸而使我们的方法受到阻碍(DSH中的冲浪视频)。然而在这些非最优表现的领域上,我们的方法仅次于表现最好的基线方法。平均而言,在所有领域中,我们的方法比性能最好的基线方法高出4%-12%的绝对值。

PHD2[11]。我们在表2中报告了跨数据集的mAP。考虑到在这个数据集的视频中检测到大量的人类数量,我们的方法比表现最好的基线方法高出4%。

SumMe[15]。我们在表4中报告了整个数据集的平均F分数。按照之前的方法[52,42],我们随机选择20%的数据集来计算平均F分数,重复这个实验5次,并报告平均性能。基于这些实验,我们比表现最好的基线方法高出4%的绝对值。这些结果表明,我们使用以人为中心的模式来检测高亮的方法在所有基准数据集上表现出了最先进的性能。

表1:在DSH数据集[47]上的平均精度。粗体:最好,下划线:第二好。我们方法在冲浪领域表现第二好,因为没有检测到足够的姿势和面孔,而在所有其他领域表现最好。

表2:PHD2[11]的平均精度。粗体:最好,下划线:第二好。

表3:TVSum数据集[46]上的平均平均精度。域名的完整形式见第5.1节。粗体:最好,下划线:第二好。我们的方法在不完全以人类为中心的领域(BK、DS、GA、MS)表现第二,在所有其他领域表现最好。

表4:SumMe数据集[15]上的F分数。粗体:最好,下划线:第二好。

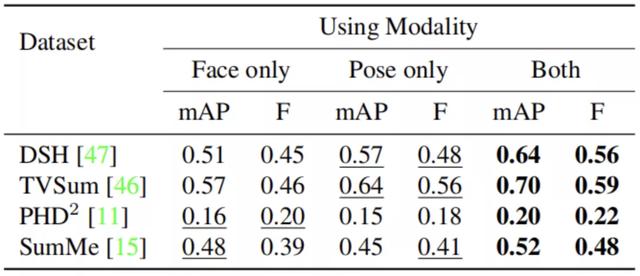

5.5. 消融研究

在我们的工作中,我们考虑了两种模式,姿势和面孔。我们依次废除这两种模态,并通过在剩余的模态上训练网络来测试我们方法的性能。我们在表5中报告了我们方法的消融版本在所有四个基准数据集的视频中的平均mAP和平均F分数。

表5:在基准数据集上,我们的方法的不同消融版本的平均mAP和平均f分数的比较。粗体:最好,下划线:第二好。

我们观察到与使用这两种模式相比,仅使用姿势而不使用人脸的方法在数据集中平均 mAP 的绝对值下降了 5%-7%,平均 F 得分下降了 3%-8%。然而,我们观察到只使用面孔而不使用姿势的方法,造成更严重的下降,平均mAP的绝对值下降4%-13%,平均F分数下降2%-13%。这是因为姿势在以人为中心的视频中更为丰富,而且比面部地标更容易被检测到。例如,即使人类被部分遮挡,在黑暗环境中或被不清晰聚焦时,姿势也可以被检测到,而检测到面部标志需要面部有良好的光线和聚焦。因此,不检测姿势造成大量的摘录损失。这一趋势只在PHD2中发生逆转,因为在那里面孔比姿势更容易被检测到。

我们还在图5中展示了我们的方法及其所有消融版本在DSH、PHD2、TVSum和SuMMe四个数据集中的一个样本视频的定性性能结果。我们可以看到,当只观察姿势而不是面孔时,我们的方法无法检测到主要有面部表情和情绪的代表性摘录。相反,当只观察面孔而不是姿势时,我们的方法只能检测面孔突出的摘录,而忽略面孔太小、太遮挡或在黑暗中的摘录。使用这两种模式,我们的方法可以检测到所有有代表性的摘录。

图5:通过我们的方法检测到的高亮显示示例帧。我们展示了使用我们方法不同消融版本检测到的高亮分数范围内的样本视频帧。我们展示了来自数据集SumMe[15](左上)、PHD2[11](右上)、DSH[47](左下)和TVSum[46](右下)的一个示例视频。当只使用面孔或姿势时,我们的方法只基于面部或姿势的代表性来学习高亮分数。结合这两种模式,我们的方法学习基于代表性的突出分数。

5.6. 突出显示分数阈值的效果

在我们的方法中,我们使用高亮分数的阈值来检测高于该阈值的高光摘录。我们在图4中显示了我们的阈值对DSH数据集中[47]中每个域的平均精度(mAP)的影响。我们观察到,随着我们对阈值的增加,mAP的总体趋势逐渐下降,因为我们的方法返回的高光点越来越少。但是,对于某些领域(例如冲浪)而言,情况并非如此,因为其中代表性摘录的高亮分数已经足够高。在实践中,我们考虑阈值的选择取决于用户的偏好,因此我们建议将它作为可供用户为每个视频配置的参数。

图4:不同高亮阈值下的的平均AP得分。在DSH数据集中[47]中的域上。

6. 结论、局限性及未来的工作

我们提出了一种新的基于神经网络的方法来检测以人为中心的视频中的高亮点。我们的方法可以利用视频中可观察到的以人为中心的模式,如面部和姿势,并自动使用这些模式来检测视频中最具代表性的亮点。在特定领域的高光(DSH)数据集[47]、个人高光检测数据集(PHD2)[11]、TVSum数据集[46]和SumMe数据集[15]上的广泛实验结果表明,与几个最先进的基线方法相比,我们提出的方法拥有更好的性能。

不过我们的方法也有一定的局限性。虽然我们的网络设计为可以容纳任意数量的模式,但我们只在基准测试中使用了具有最好平均性能的人脸和姿态两种模式。然而,许多视频(例如,关于梳理动物的视频,制作三明治的视频TVSum)展示了其他模式,如手和手指。因此,我们计划在未来将更多以人类为中心的模式纳入我们的实验中。我们的方法可能不会为以非人类为中心的视频提供太多的性能提升,如通常关注其他类别的生命或无生命物体或自然场景的视频。我们计划在未来使用适当的模式来探索这些领域。我们的方法还可以与特定领域的特性相结合,或与用户偏好相适应,通过微调以检测出更多的高亮点。

参考文献

[1] Hillel Aviezer, Yaacov Trope, and Alexander Todorov. Body cues, not facial expressions, discriminate between intense positive and negative emotions. Science, 338(6111):1225–1229, 2012. 2

[2] Uttaran Bhattacharya, Trisha Mittal, Rohan Chandra, Tanmay Randhavane, Aniket Bera, and Dinesh Manocha. Step: Spatial temporal graph convolutional networks for emotion perception from gaits. In Proceedings of the Thirty-Fourth AAAI Conference on Artificial Intelligence (AAAI-20), page 1342–1350. AAAI Press, 2020. 2, 3

[3] Carlos Busso, Murtaza Bulut, Chi-Chun Lee, Abe Kazemzadeh, Emily Mower, Samuel Kim, Jeannette N Chang, Sungbok Lee, and Shrikanth S Narayanan. Iemocap: Interactive emotional dyadic motion capture database. Language resources and evaluation, 42(4):335, 2008. 3

[4] Sijia Cai, Wangmeng Zuo, Larry S. Davis, and Lei Zhang. Weakly-supervised video summarization using variational encoder-decoder and web prior. In Proceedings of the European Conference on Computer Vision (ECCV), September 2018. 2

[5] C. Chen, R. Jafari, and N. Kehtarnavaz. Utd-mhad: A multimodal dataset for human action recognition utilizing a depth camera and a wearable inertial sensor. In 2015 IEEE International Conference on Image Processing (ICIP), pages 168–172, 2015. 3

[6] Chong-Wah Ngo, Yu-Fei Ma, and Hong-Jiang Zhang. Automatic video summarization by graph modeling. In Proceedings Ninth IEEE International Conference on Computer Vision, pages 104–109 vol.1, 2003. 2

[7] Wen-Sheng Chu, Yale Song, and Alejandro Jaimes. Video co-summarization: Video summarization by visual cooccurrence. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 2015. 2, 6, 7

[8] Cisco. Annual internet report (2018–2023): https://www.cisco.com/c/en/us/solutions/collateral/service-provider/visual-networking-index-vni/complete-white-paper-c11-481360.html# toc484813989. CISCO White paper, 2020. 1

[9] Micha¨el Defferrard, Xavier Bresson, and Pierre Vandergheynst. Convolutional neural networks on graphs with fast localized spectral filtering. In D. D. Lee, M. Sugiyama, U. V. Luxburg, I. Guyon, and R. Garnett, editors, Advances in Neural Information Processing Systems 29, pages 3844–3852. Curran Associates, Inc., 2016. 4

[10] Annalisa Franco, Antonio Magnani, and Dario Maio. A multimodal approach for human activity recognition based on skeleton and rgb data. Pattern Recognition Letters, 131:293–299, 2020. 3

[11] Ana Garcia del Molino and Michael Gygli. Phd-gifs: Personalized highlight detection for automatic gif creation. In Proceedings of the 26th ACM International Conference on Multimedia, MM ’18, page 600–608, New York, NY, USA, 2018. Association for Computing Machinery. 1, 2, 6, 7, 8

[12] Adam Geitgey. Face Recognition, 2020. 3, 4, 5

[13] Boqing Gong, Wei-Lun Chao, Kristen Grauman, and Fei Sha. Diverse sequential subset selection for supervised video summarization. In Z. Ghahramani, M. Welling, C. Cortes, N. Lawrence, and K. Q. Weinberger, editors, Advances in Neural Information Processing Systems, volume 27, pages 2069–2077. Curran Associates, Inc., 2014. 2

[14] Hongxiang Gu and Viswanathan Swaminathan. From thumbnails to summaries-a single deep neural network to rule them all. In 2018 IEEE International Conference on Multimedia and Expo (ICME), pages 1–6. IEEE, 2018. 2, 4

[15] Michael Gygli, Helmut Grabner, Hayko Riemenschneider, and Luc Van Gool. Creating summaries from user videos. In David Fleet, Tomas Pajdla, Bernt Schiele, and Tinne Tuytelaars, editors, Computer Vision – ECCV 2014, pages 505–520, Cham, 2014. Springer International Publishing. 2, 6, 7, 8

[16] Michael Gygli, Helmut Grabner, and Luc Van Gool. Video summarization by learning submodular mixtures of objectives. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 2015. 2, 6, 7

[17] Michael Gygli, Yale Song, and Liangliang Cao. Video2gif: Automatic generation of animated gifs from video. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 2016. 2, 6, 7

[18] Yifan Jiao, Zhetao Li, Shucheng Huang, Xiaoshan Yang, Bin Liu, and Tianzhu Zhang. Three-dimensional attention-based deep ranking model for video highlight detection. IEEE Transactions on Multimedia, 20(10):2693–2705, 2018. 2

[19] Yifan Jiao, Tianzhu Zhang, Shucheng Huang, Bin Liu, and Changsheng Xu. Video highlight detection via region-based deep ranking model. International Journal of Pattern Recognition and Artificial Intelligence, 33(07):1940001, 2019. 2

[20] Hideo Joho, Jacopo Staiano, Nicu Sebe, and Joemon M Jose. Looking at the viewer: analysing facial activity to detect personal highlights of multimedia contents. Multimedia Tools and Applications, 51(2):505–523, 2011. 2

[21] Hanbyul Joo, Tomas Simon, Xulong Li, Hao Liu, Lei Tan, Lin Gui, Sean Banerjee, Timothy Scott Godisart, Bart Nabbe, Iain Matthews, Takeo Kanade, Shohei Nobuhara, and Yaser Sheikh. Panoptic studio: A massively multiview system for social interaction capture. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017. 5

[22] Aditya Khosla, Raffay Hamid, Chih-Jen Lin, and Neel Sundaresan. Large-scale video summarization using web-image priors. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 2013. 2

[23] Gunhee Kim, Leonid Sigal, and Eric P. Xing. Joint summarization of large-scale collections of web images and videos for storyline reconstruction. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 2014. 1, 2

[24] Gunhee Kim and Eric P. Xing. Reconstructing storyline graphs for image recommendation from web community photos. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 2014. 2

[25] Hoseong Kim, Tao Mei, Hyeran Byun, and Ting Yao. Exploiting web images for video highlight detection with triplet deep ranking. IEEE Transactions on Multimedia,

20(9):2415–2426, 2018. 1, 2

[26] Yelin Kim, Honglak Lee, and Emily Mower Provost. Deep learning for robust feature generation in audiovisual emotion recognition. ICASSP, pages 3687–3691, 2013. 3

[27] Diederik P Kingma and Jimmy Ba. Adam: A method for stochastic optimization. arXiv preprint arXiv:1412.6980, 2014. 5

[28] Thomas N Kipf and Max Welling. Semi-supervised classification with graph convolutional networks. arXiv preprint arXiv:1609.02907, 2016. 4

[29] Muhammed Kocabas. Simple Multi Person Tracker, 2019. 3, 4, 5

[30] Y. J. Lee, J. Ghosh, and K. Grauman. Discovering important people and objects for egocentric video summarization. In 2012 IEEE Conference on Computer Vision and Pattern Recognition, pages 1346–1353, 2012. 2

[31] Ang Li, Meghana Thotakuri, David A Ross, Jo˜ao Carreira, Alexander Vostrikov, and Andrew Zisserman. The ava-kinetics localized human actions video dataset. arXiv preprint arXiv:2005.00214, 2020. 5

[32] G. Li, Y. Zhao, M. Ji, X. Yuan, and L. Fang. Zoom in to the details of human-centric videos. In 2020 IEEE International Conference on Image Processing (ICIP), pages 3089–3093, 2020. 2

[33] Jianan Li, Xuemei Xie, Qingzhe Pan, Yuhan Cao, Zhifu Zhao, and Guangming Shi. Sgm-net: Skeleton-guided multimodal network for action recognition. Pattern Recognition, 104:107356, 2020. 3

[34] S. Li and W. Deng. Deep facial expression recognition: A survey. IEEE Transactions on Affective Computing, pages 1–1, 2020. 2

[35] Zheng Lu and Kristen Grauman. Story-driven summarization for egocentric video. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 2013. 2, 7

[36] Behrooz Mahasseni, Michael Lam, and Sinisa Todorovic. Unsupervised video summarization with adversarial lstm networks. In Proceedings of the IEEE conference on Computer Vision and Pattern Recognition, pages 202–211, 2017. 1, 2, 4, 6, 7

[37] D. Mehta, O. Sotnychenko, F. Mueller, W. Xu, S. Sridhar, G. Pons-Moll, and C. Theobalt. Single-shot multi-person 3d pose estimation from monocular rgb. In 2018 International Conference on 3D Vision (3DV), pages 120–130, 2018. 5

[38] Trisha Mittal, Uttaran Bhattacharya, Rohan Chandra, Aniket Bera, and Dinesh Manocha. M3er: Multiplicative multimodal emotion recognition using facial, textual, and speech cues. In Proceedings of the Thirty-Fourth AAAI Conference on Artificial Intelligence, AAAI’20, pages 1359–1367. AAAI Press, 2020. 2, 3

[39] Trisha Mittal, Pooja Guhan, Uttaran Bhattacharya, Rohan Chandra, Aniket Bera, and Dinesh Manocha. Emoticon: Context-aware multimodal emotion recognition using frege’s principle. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 2020. 3

[40] Rameswar Panda and Amit K. Roy-Chowdhury. Collaborative summarization of topic-related videos. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 2017. 2, 6, 7

[41] Danila Potapov, Matthijs Douze, Zaid Harchaoui, and Cordelia Schmid. Category-specific video summarization. In David Fleet, Tomas Pajdla, Bernt Schiele, and Tinne Tuytelaars, editors, Computer Vision – ECCV 2014, pages 540–555, Cham, 2014. Springer International Publishing. 2, 6, 7

[42] Mrigank Rochan, Mahesh Kumar Krishna Reddy, Linwei Ye, and Yang Wang. Adaptive video highlight detection by learning from user history. In Proceedings of the European Conference on Computer Vision (ECCV), August 2020. 1, 2, 4, 6, 7

[43] Mrigank Rochan and Yang Wang. Video summarization by learning from unpaired data. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern

Recognition (CVPR), June 2019. 2

[44] Mrigank Rochan, Linwei Ye, and Yang Wang. Video summarization using fully convolutional sequence networks. In Proceedings of the European Conference on Computer Vision (ECCV), September 2018. 1, 2, 6, 7

[45] A. Shahroudy, T. Ng, Y. Gong, and G. Wang. Deep multimodal feature analysis for action recognition in rgb+d videos. IEEE Transactions on Pattern Analysis and Machine Intelligence, 40(5):1045–1058, 2018. 3

[46] Yale Song, Jordi Vallmitjana, Amanda Stent, and Alejandro Jaimes. Tvsum: Summarizing web videos using titles. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 2015. 2, 6, 7, 8

[47] Min Sun, Ali Farhadi, and Steve Seitz. Ranking domain specific highlights by analyzing edited videos. In European conference on computer vision, pages 787–802. Springer, 2014. 1, 2, 4, 6, 7, 8

[48] Zongheng Tang, Yue Liao, Si Liu, Guanbin Li, Xiaojie Jin, Hongxu Jiang, Qian Yu, and Dong Xu. Human-centric spatio-temporal video grounding with visual transformers. arXiv preprint arXiv:2011.05049, 2020. 2

[49] Ba Tu Truong and Svetha Venkatesh. Video abstraction: A systematic review and classification. ACM Trans. Multimedia Comput. Commun. Appl., 3(1):3–es, Feb. 2007. 2

[50] Paul Vicol, Makarand Tapaswi, Llu´ıs Castrej´on, and Sanja Fidler. Moviegraphs: Towards understanding human-centric situations from videos. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 2018. 1, 2

[51] Xueyang Wang, Xiya Zhang, Yinheng Zhu, Yuchen Guo, Xiaoyun Yuan, Liuyu Xiang, Zerun Wang, Guiguang Ding, David Brady, Qionghai Dai, and Lu Fang. Panda: A gigapixel-level human-centric video dataset. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 2020. 2

[52] Zijun Wei, Boyu Wang, Minh Hoai Nguyen, Jianming Zhang, Zhe Lin, Xiaohui Shen, Radomir Mech, and Dimitris Samaras. Sequence-to-segment networks for segment detection. In S. Bengio, H. Wallach, H. Larochelle, K. Grauman, N. Cesa-Bianchi, and R. Garnett, editors, Advances in Neural Information Processing Systems, volume 31, pages 3507–3516. Curran Associates, Inc., 2018. 2, 6, 7

[53] Bo Xiong, Yannis Kalantidis, Deepti Ghadiyaram, and Kristen Grauman. Less is more: Learning highlight detection from video duration. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 1258–1267, 2019. 1, 2, 4, 6, 7

[54] Bo Xiong, Gunhee Kim, and Leonid Sigal. Storyline representation of egocentric videos with an applications to story-based search. In Proceedings of the IEEE International Conference on Computer Vision (ICCV), December 2015. 2

[55] Jia Xu, Lopamudra Mukherjee, Yin Li, Jamieson Warner, James M. Rehg, and Vikas Singh. Gaze-enabled egocentric video summarization via constrained submodular maximization. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 2015. 2

[56] Sijie Yan, Yuanjun Xiong, and Dahua Lin. Spatial temporal graph convolutional networks for skeleton-based action recognition. In Sheila A. McIlraith and Kilian Q. Weinberger, editors, Proceedings of the Thirty-Second AAAI Conference on Artificial Intelligence, (AAAI-18), pages 7444–7452. AAAI Press, 2018. 2, 3, 4

[57] Huan Yang, Baoyuan Wang, Stephen Lin, David Wipf, Minyi Guo, and Baining Guo. Unsupervised extraction of video highlights via robust recurrent auto-encoders. In Proceedings of the IEEE International Conference on Computer Vision (ICCV), December 2015. 2, 6, 7

[58] Ting Yao, Tao Mei, and Yong Rui. Highlight detection with pairwise deep ranking for first-person video summarization. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 982–990, 2016. 2

[59] Minerva Yeung, Boon-Lock Yeo, and Bede Liu. Segmentation of video by clustering and graph analysis. Computer Vision and Image Understanding, 71(1):94 – 109, 1998. 2

[60] Youngjae Yu, Sangho Lee, Joonil Na, Jaeyun Kang, and Gunhee Kim. A deep ranking model for spatio-temporal highlight detection from a 360 video. pages 7525–7533, 2018. 2

[61] AmirAli Bagher Zadeh, Paul Pu Liang, Soujanya Poria, Erik Cambria, and Louis-Philippe Morency. Multimodal language analysis in the wild: Cmu-mosei dataset and interpretable dynamic fusion graph. In ACL (Volume 1: Long Papers), pages 2236–2246, 2018. 3

[62] Wenjun Zeng. Toward human-centric deep video understanding. APSIPA Transactions on Signal and Information Processing, 9:e1, 2020. 1

[63] Ke Zhang, Wei-Lun Chao, Fei Sha, and Kristen Grauman. Video summarization with long short-term memory. In Bastian Leibe, Jiri Matas, Nicu Sebe, and Max Welling, editors, Computer Vision – ECCV 2016, pages 766–782, Cham, 2016. Springer International Publishing. 1, 2, 6, 7

[64] Ke Zhang, Kristen Grauman, and Fei Sha. Retrospective encoders for video summarization. In Proceedings of the European Conference on Computer Vision (ECCV), September 2018. 1, 2

[65] Bin Zhao, Xuelong Li, and Xiaoqiang Lu. Hierarchical recurrent neural network for video summarization. In Proceedings of the 25th ACM International Conference on Multimedia, MM ’17, page 863–871, New York, NY, USA, 2017. Association for Computing Machinery. 2

[66] Bin Zhao and Eric P. Xing. Quasi real-time summarization for consumer videos. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 2014. 2

[67] Kaiyang Zhou, Yu Qiao, and Tao Xiang. Deep reinforcement learning for unsupervised video summarization with diversity-representativeness reward. pages 7582–7589, 2018. 1, 2, 6, 7

2、2020年是建党多少周年:2020年是建党多少年呢

99年

2020年是建党99年。中国共产党,简称中共,创建于1921年7月23日,历经多年国共内战,中国共产党在中国大陆和绝大多数沿海岛屿取得全面胜利,率领中国人民解放军打败中华民国国军,迫使中华民国政府退守台澎金马,并在1949年于北京建立中华人民共和国。

2020年是建党99年。中国共产党于1921年7月23日成立后,在反动军阀政府的残暴统治之下,只能处于秘密状态,没有公开进行活动的环境。在大革命时期,党忙于国共合作、开展工农运动和支援北伐战争,没有条件对党的诞生进行纪念。把7月1日作为中国共产党的诞辰纪念日,是毛泽东同志于1938年5月提出来的。当时,毛泽东在《论持久战》一文中提出:“今年七月一日,是中国共产党建立的十七周年纪念日”。这是中央领导同志第一次明确提出“七一”是党的诞生纪念日。

把7月1日作为党的诞生纪念日,是毛泽东于1938年5月提出来的。当时,毛泽东在《论持久战》一文中提出:“今年七月一日,是中国共产党建立十七周年纪念日。”这是中央领导同志第一次明确提出“七一”是党的诞生纪念日。当时在延安的曾经参加过一大的党的创始人只有毛泽东、董必武两人。他们回忆一大是7月份召开的,但记不清楚确切的开会日期。因为缺乏档案材料,一时无法查证,所以就把7月1日确定为党的诞生纪念日。

“七一”作为党的诞生纪念日,最早见于中央文件是1941年6月。当时,中共中央发出《关于中国共产党诞生二十周年、抗日四周年纪念指示》。《指示》说:“今年七一是中共产生的二十周年,七七是中国抗日战争的四周年,各抗日根据地应分别召集会议,采取各种办法,举行纪念,并在各种刊物出特刊或特辑。”这是以中共中央名义作出的把“七一”作为党的诞生纪念日进行纪念的第一个文件。

党的一大开幕日期到20世纪70年代末才由党史工作者考证清楚,根据新发现的史料和考证成果,确定一大的召开日期是1921年7月23日。虽然党的诞生纪念日并不是党的一大召开的具体日期,“七一”这个光辉的节日已经深深地铭刻在全党和全国各族人民的心中。它成为人们每年进行纪念的一个重要节日,也成为中国节日文化的一部分。

声明:本篇经验系「www.coozhi.com」原创,转载请注明出处。

本文关键词:建党到2020年多少年了,2020是建党多少年?,2020年已经建党多少年了,2020年是建党多少年呢,2020年建党已经多少年了。这就是关于《2020年是建党多少周年,2020年是建党多少年呢(Adobe提出短视频集锦自动生成新方法)》的所有内容,希望对您能有所帮助!